Ale się porobiło! Jeszcze tydzień temu temat, o którym dzisiaj piszę, miałby zupełnie inny wydźwięk. A tu w poprzedni poniedziałek został opublikowany nowy model DeepSeek-R1.

Tak to wszystko wywróciło, że odwołuję webinar z tego tygodnia, ale spokojnie - są kolejne wideo z serii “AI w minutę”.

AI zacierają (zacierały?) ręce na AI

Cóż to za piękne czasy nastały dla CEO i akcjonariuszy wielkich firm, które w jakikolwiek sposób tworzą coś z AI. Mówię tu głównie o gigantach typu Nvidia, Microsoft, Google, Amazon, ale też OpenAI planujące zmonetyzować sukces swoich modeli GPT.

Dlaczego? Oto najważniejsze powody:

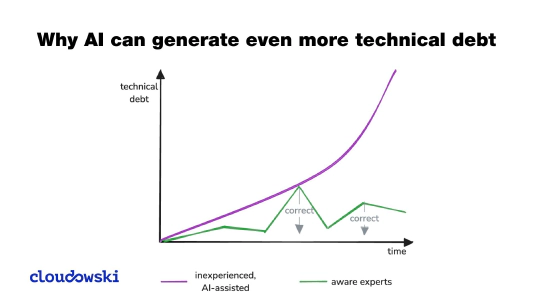

- Modele AI (LLM i inne) wymagają do wytrenowania danych, ale głównie mocy obliczeniowej. Do tego używa się drogich kart GPU i ci co je mają lub produkują, patrzą na słupki rosnących cen akcji i planują wcześniejsze emerytury.

- Nawet jak nie produkujesz kart GPU (czyli nie jesteś firmą Nvidia) to nadal możesz wskoczyć na ten okręt, gdyż nie tylko potrzeba kart GPU, ale też dużo prądu, storage i compute do serwowania tych modeli klientom płacącym za tokeny wysyłane do modeli.

Kilka dni temu ogłoszono, że pewna grupa firm zainwestuje 500 miliardów dolarów w taką infrastrukturę przewidując spory popyt na AI uruchamianie w nowiutkich datacenter. - W przeciwieństwie do “zwykłych” aplikacji uruchamianych od kilkunastu już lat w chmurze, aplikacje/agenty i modele AI mają zdecydowanie większą grupę odbiorców. Oznacza to, że będzie to jeszcze bardziej dochodowe. <sarkazm>Wymazywanie nieznajomych z naszych fotek z wakacji</sarkazm>, ale też inne i naprawdę ważne zastosowania mają już grupę odbiorców, która będzie tylko rosła.

- Nawet jak organizacje pragnące użyć modeli zechcą je uruchomić na własnych serwerach to… i tak będą potrzebowały kupić karty GPU. Gdzieś dolary i tak wyślą.

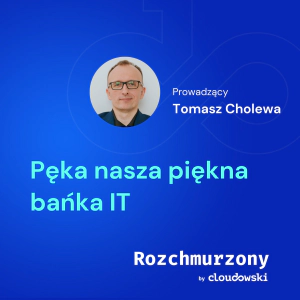

I to było prawdą do czasu opublikowania chińskiego modelu DeepSeek-R1. To spowodowało olbrzymie zawirowanie, ponieważ:

- Ten model został wytrenowany o wiele, wiele taniej. Niektóre źródła mówią o 3-5% kosztów modelu GPT-4o (podobno 5-6 milionów dolarów).

- Ich model okazuje się dorównywać i czasem prześcigać w testach głównego, o wiele droższego rywala GPT-4o.

- W przeciwieństwie do modeli od OpenAI model DeepSeek jest nie tylko możliwy do uruchomienia lokalnie (jest już do uruchomienia na Ollama), ale też open source. Oznacza to, że teraz inni będą mogli stworzyć podobne modele również taniej.

To spowodowało niezłe zawirowania na giełdzie, bo inwestorzy przestają wierzyć w zapewnienia CEO tych wielkich amerykańskich korporacji o olbrzymich zyskach, skoro można będzie taniej tworzyć i uruchamiać takie modele. I to poza chmurą.

To pewien prztyczek w nos na Chin w stronę USA, ale ten newsletter jest o technologii, a nie polityce więc zostawię to jako ciekawostkę.

Co się wydarzy dalej? Z pewnością jest to bardziej optymistyczne i bardziej demokratyczne podejście do AI w duchu open source.

🍿 Zobaczymy co przyniesie najbliższa przyszłość.

Odwołany webinar

Jestem zmuszony odwołać webinar zaplanowany na najbliższy czwartek. To głównie przez to co się wydarzyło z ogłoszeniem DeepSeek i stwierdziłem, że potrzebuję więcej czasu na przygotowanie treści mającej odwołanie do tej nowej rzeczywistości.

Przepraszam, ale co się odwlecze to nie uciecze.

Do tego czasu oczywiście będę publikował nowe wideo z serii “AI w minutę” i dalej zgłębiał praktyczne strony AI.

Nowe części serii “AI w minutę”

Przedstawiam dostępne wideo z mojej treściwej serii filmów o AI. Skończyłem nagrywanie kolejnych części - będzie ich łącznie 22.

Trwa ich montaż, gdyż pomimo, że każdy z nich trwa około minuty to ich przygotowanie jest o wieeeele dłuższe.

1: Jaka jest różnica między AI a LLM?

2: Czym jest LLM?

3: Jak powstaje LLM?

4: Jaka działa LLM?

5: Czym są parametry w LLM?

6: Ile kosztuje korzystanie z LLM?

7: Czym jest self-attention?

8: Czym jest cutoff w LLM? (niepubliczne - obecnie dostępne tylko dla subskrybentów)

9: Czym są tokeny? (już w poniedziałek 3 lutego)

Comments